8G 显存玩转书生大模型 Demo

今天来学习一下,如何部署大模型

关卡任务

本关任务主要包括:

- InternLM2-Chat-1.8B 模型的部署(基础任务)

- InternLM-XComposer2-VL-1.8B 模型的部署(进阶任务)

- InternVL2-2B 模型的部署(进阶任务

环境配置

我们首先来为 Demo 创建一个可用的环境。

1 | # 创建环境 |

Cli Demo 部署 InternLM2-Chat-1.8B 模型

首先,我们创建一个目录,用于存放我们的代码。并创建一个 cli_demo.py。

1 | mkdir -p /root/demo |

然后,我们将下面的代码复制到 cli_demo.py 中。

1 | import torch |

接下来,我们便可以通过 python /root/demo/cli_demo.py 来启动我们的 Demo。

效果如下图所示:

LMDeploy 部署 InternLM-XComposer2-VL-1.8B 模型

InternLM-XComposer2 是一款基于 InternLM2 的视觉语言大模型,其擅长自由形式的文本图像合成和理解。其主要特点包括:

- 自由形式的交错文本图像合成:InternLM-XComposer2 可以根据大纲、详细文本要求和参考图像等不同输入,生成连贯且上下文相关,具有交错图像和文本的文章,从而实现高度可定制的内容创建。

- 准确的视觉语言问题解决:InternLM-XComposer2 基于自由形式的指令准确地处理多样化和具有挑战性的视觉语言问答任务,在识别,感知,详细标签,视觉推理等方面表现出色。

- 令人惊叹的性能:基于 InternLM2-7B 的InternLM-XComposer2 在多个基准测试中位于开源多模态模型第一梯队,而且在部分基准测试中与 GPT-4V 和 Gemini Pro 相当甚至超过它们。

LMDeploy 是一个用于压缩、部署和服务 LLM 的工具包,由 MMRazor 和 MMDeploy 团队开发。它具有以下核心功能: - 高效的推理:LMDeploy 通过引入持久化批处理、块 KV 缓存、动态分割与融合、张量并行、高性能 CUDA 内核等关键技术,提供了比 vLLM 高 1.8 倍的推理性能。

- 有效的量化:LMDeploy 支持仅权重量化和 k/v 量化,4bit 推理性能是 FP16 的 2.4 倍。量化后模型质量已通过 OpenCompass 评估确认。

- 轻松的分发:利用请求分发服务,LMDeploy 可以在多台机器和设备上轻松高效地部署多模型服务。

- 交互式推理模式:通过缓存多轮对话过程中注意力的 k/v,推理引擎记住对话历史,从而避免重复处理历史会话。

- 优秀的兼容性:LMDeploy支持 KV Cache Quant,AWQ 和自动前缀缓存同时使用。

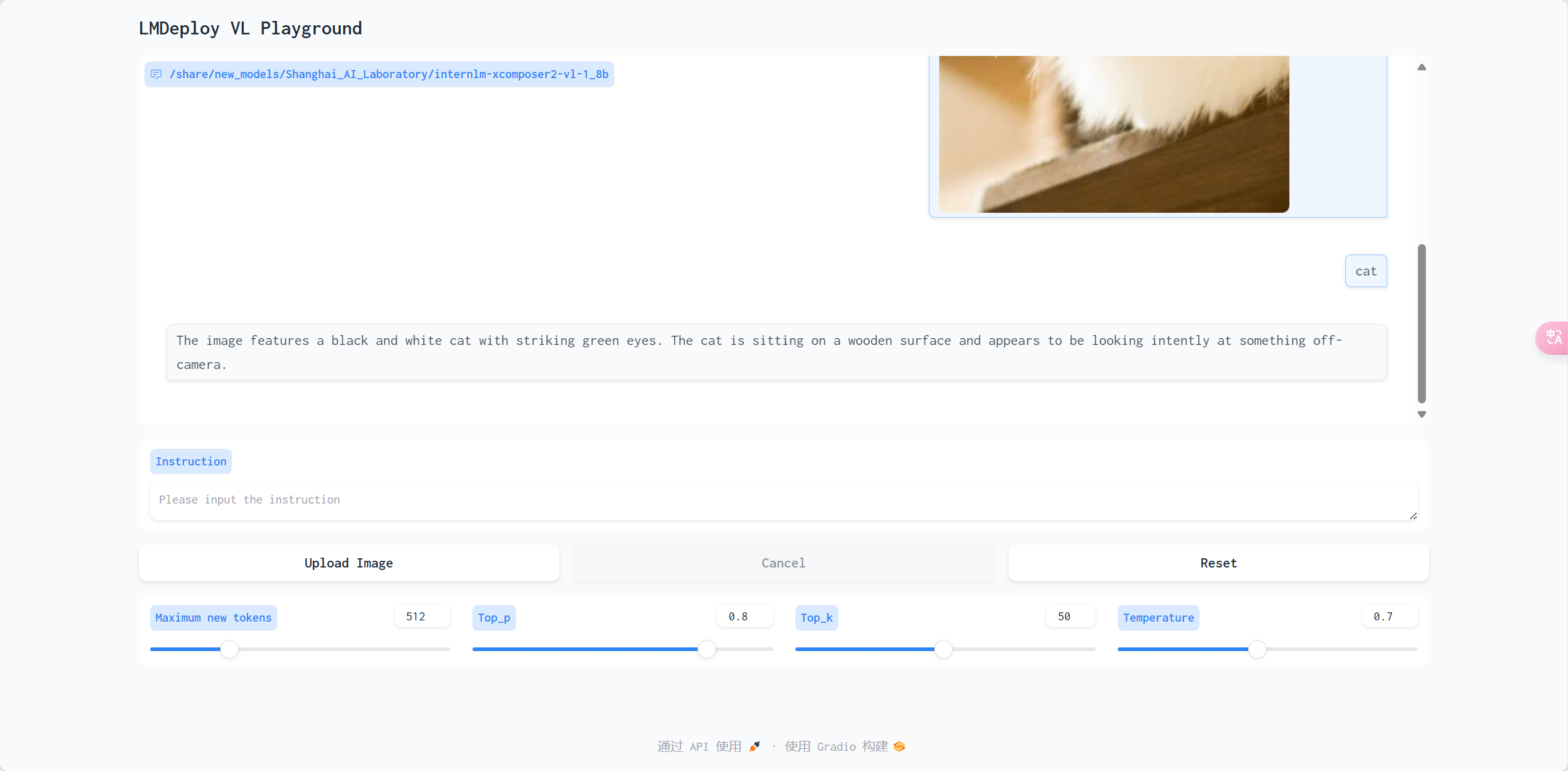

LMDeploy 已经支持了 InternLM-XComposer2 系列的部署,但值得注意的是 LMDeploy 仅支持了 InternLM-XComposer2 系列模型的视觉对话功能。

接下来,我们将演示如何使用 LMDeploy 部署 InternLM-XComposer2-VL-1.8B 模型。

首先,我们激活环境并安装 LMDeploy 以及其他依赖。

1 | conda activate demo |

接下来,我们使用 LMDeploy 启动一个与 InternLM-XComposer2-VL-1.8B 模型交互的 Gradio 服务。

1 | lmdeploy serve gradio /share/new_models/Shanghai_AI_Laboratory/internlm-xcomposer2-vl-1_8b |

接下来,我们在本地的 PowerShell 中输入以下命令,将端口映射到本地。

1 | ssh -CNg -L 6006:127.0.0.1:6006 root@ssh.intern-ai.org.cn -p 你的 ssh 端口号 |

在完成端口映射后,我们便可以通过浏览器访问 http://localhost:6006 来启动我们的 Demo。

在使用 Upload Image 上传图片后,我们输入 Instruction 后按下回车,便可以看到模型的输出。

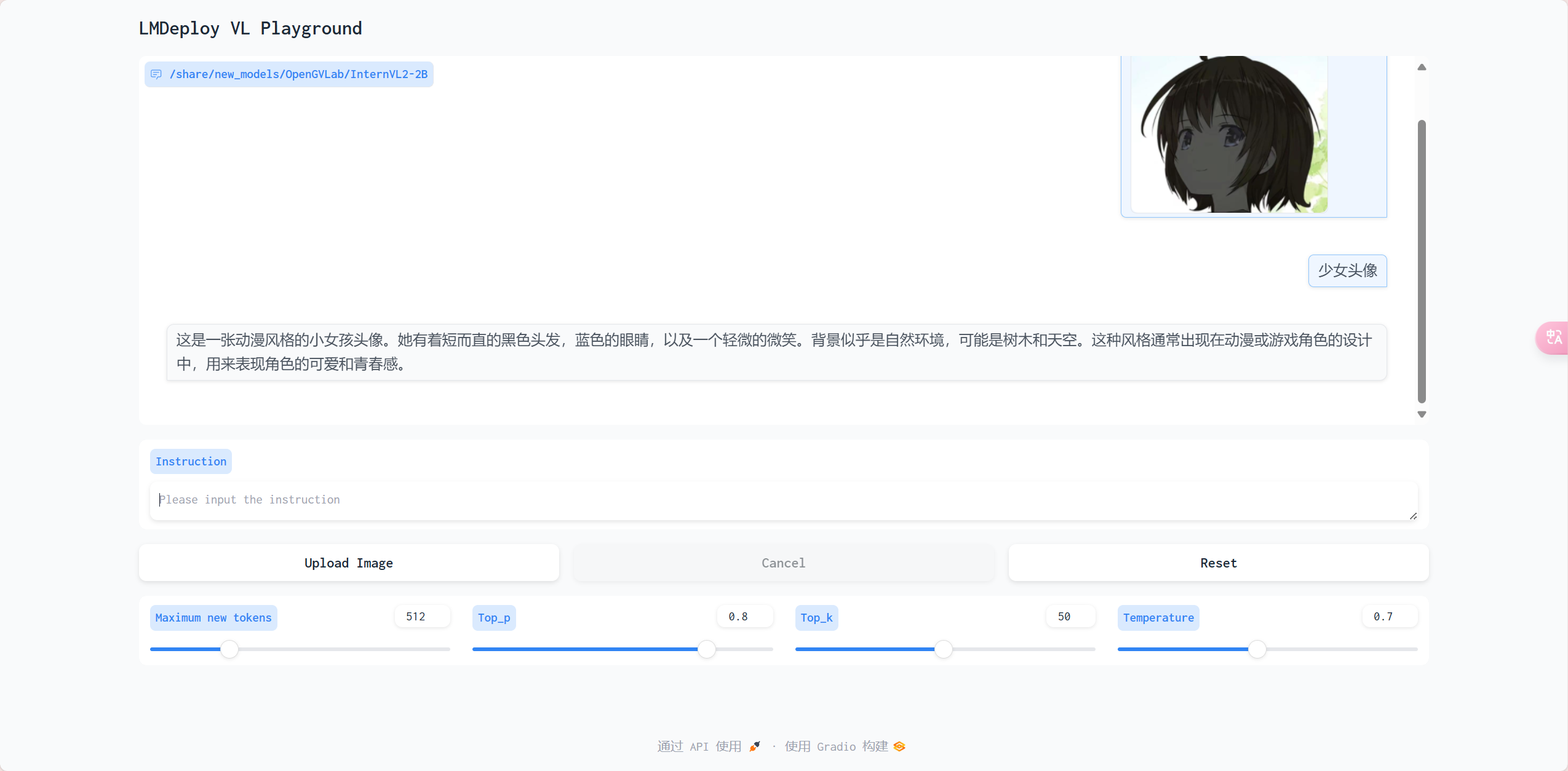

MDeploy 部署 InternVL2-2B 模型

InternVL2 是上海人工智能实验室推出的新一代视觉-语言多模态大模型,是首个综合性能媲美国际闭源商业模型的开源多模态大模型。InternVL2 系列从千亿大模型到端侧小模型全覆盖,通专融合,支持多种模态。

LMDeploy 也已经支持了 InternVL2 系列模型的部署,让我们一起来使用 LMDeploy 部署 InternVL2-2B 模型。

我们可以通过下面的命令来启动 InternVL2-2B 模型的 Gradio 服务。

1 | conda activate demo |

在完成端口映射后,我们便可以通过浏览器访问 http://localhost:6006 来启动我们的 Demo。

在使用 Upload Image 上传图片后,我们输入 Instruction 后按下回车,便可以看到模型的输出。